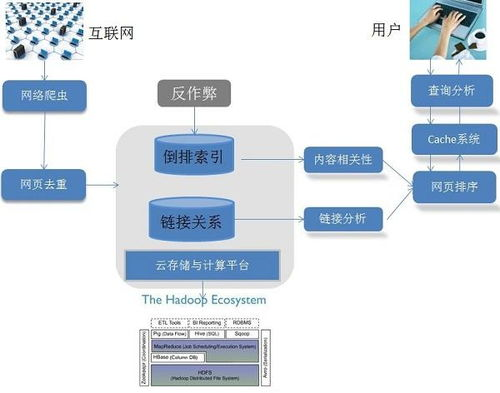

一、搜索引擎的架构基础

搜索引擎主要由三个核心部分构成:爬虫(Crawler)、索引(Index)和搜索算法(Search Algorithm)。这三个部分协同工作,确保用户能够快速找到所需信息。

二、爬虫的工作原理与优化

爬虫负责在互联网上搜集网页信息。为了提高爬取效率,爬虫会优先访问更新频率高、重要性大的网页。优化爬虫的关键在于合理设置爬取频率和策略,以减少对目标服务器的影响。

在搜索引擎优化(SEO)中,确保网站结构清晰、robots.txt文件设置合理,有助于爬虫更好地理解和抓取网站内容。

三、索引的构建与维护

索引是搜索引擎的核心,它存储了所有被爬虫抓取的网页信息。构建索引的过程包括分词、去重和存储。为了提高搜索效率,索引通常采用倒排索引的方式,将关键词与对应的网页进行映射。

维护索引的更新是确保搜索结果时效性的关键。定期更新索引,清除无效链接,可以提供更准确的搜索结果。

四、搜索算法的演进与优化

搜索算法负责根据用户输入的关键词,从索引库中检索出最相关的内容。从最初的布尔模型到如今的机器学习算法,搜索算法的演进一直在提高搜索的准确性和用户体验。

优化搜索算法的关键在于理解用户意图,改进排序算法,以及引入更多相关性因素,如用户的点击行为、搜索历史等。

五、搜索引擎的安全与隐私保护

随着网络安全问题的日益严峻,搜索引擎在保护用户隐私和数据安全方面也承担着重要责任。采用加密技术、匿名化处理用户数据,以及严格遵守隐私法规,是搜索引擎保护用户隐私的必要措施。

六、搜索引擎的未来发展趋势

随着人工智能技术的不断发展,搜索引擎的未来将更加智能化。语音搜索、图像搜索、视频搜索等多种形式的搜索将更加普及,为用户提供更加丰富和便捷的信息获取方式。

搜索引擎的核心构成部分相互协作,为用户提供高效、准确的信息检索服务。通过不断优化爬虫、索引和搜索算法,搜索引擎将更好地满足用户需求,引领信息检索的未来发展。

评论列表